大型語言模型(LLM)的使用優化

依照業務需求、數據可用性、應用場景及系統設計考量,採用多種方式運用大型語言模型 (LLM)。

優化層級

提示工程 (Prompt Engineering)

使用提示直接應用預訓練模型,適合簡單需求。

檢索增強生成 (RAG)

通過外部知識增強生成,適用於需要額外資訊的場合。

微調 (Fine-tuning)

使用特定領域的數據進行優化預訓練模型,以應用於特定需求。

預先訓練 (Pre-training)

訓練模型從頭開始,適用於高度定制化的應用場景。

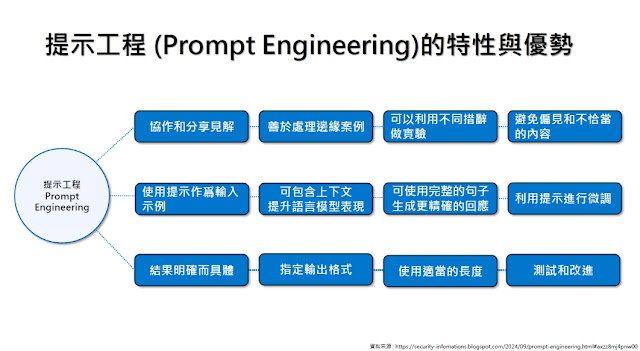

提示工程 (Prompt Engineering) 的特性與優勢

協作與共享見解

善於處理邊緣案例。

可以利用不同描述做實驗,避免偏見與不恰當內容的生成。

精確輸入與回應

使用提示作為輸入示例。

可包含上下文來提升模型表現。

使用完整句子生成更準確的回應。

利用提示進行微調。

輸出格式與持續優化

指定輸出格式,達到結果明確而具體。

設定適當的長度並進行測試和改進。

檢索增強生成 (RAG) 的工作原理

定義與目的

RAG 是將檢索方法與生成模型結合的混合技術。

模型在回答過程中運用外部知識資源,如資料庫、文件或預先存儲的知識。

工作流程

問題提出:用戶輸入問題後,RAG 系統利用智慧檢索器查詢相關資料。

資料檢索:從特定資料來源查詢文件和訊息。

生成回答:檢索到的資訊與問題一起送到語言模型,重組成為有條理的回答。

回答特性

明確引用外部資訊來源,回答具上下文關聯和準確性。

RAG とは何ですか?

定義

RAG (Retrieval-Augmented Generation) 是一種資料擴展生成模型的應用方法。

能利用檢索到的文檔進行資料擴展。

理論挑戰

將整份文件直接提供給模型參考不切實際,可能超出模型處理能力。

運作步驟

資料切片量化:資料切成小片段後量化儲存。

檢索生成:從量化後片段中找出最相似的片段,提升準確性。

RAG 資料切片量化

1. 載入資料

支援多種文件格式:CSV、PDF、JSON、DOCX、HTML 等。

2. 分割資料

將資料分割成較小的內容單位,便於處理。

3. 嵌入資料

將分割後資料轉換為向量表示。

4. 向量資料庫

儲存向量於資料庫,例如 FAISS、Chroma、Pinecone 等。

RAG 檢索生成流程

1. 將問題轉成向量

問題轉為向量格式。

2. 向量比對

在向量資料庫中檢索相似資料。

3. 檢索相關資料

找出最相關的多筆資料。

4. 語言模型生成

將相關資料和問題送入語言模型進行回答生成。

5. 得出結果

生成有條理且精確的回答。

沒有留言:

張貼留言